安妮 发自 凹非寺量子位 出品 | 公众号 QbitAI

昨天,TVM、XGBoost、cxxnet等机器学习工具的作者陈天奇宣布,自己所在的华盛顿大学新成立了一个实验室,组织代号"SAML"。

陈天奇本人在微博上介绍说,实验室将有整合系统、体系结构、机器学习和程序语言4个方向的团队推进深度学习算法、系统的硬件和协同设计研究和TVM等开源项目。

四个方向

华盛顿大学为什么想建立这个实验室?在SAML项目首页上,我们找到了答案。

我们想解决调度、网络、存储和编程抽象方面的新挑战,构建可从新兴硬件体系中受益的可扩展系统,处理不断增长的可用数据。重要的是,未来的模型和算法需要与硬件共同设计,系统级的要素需要告知硬件软件栈的设计。我们需要建立通用、可复用的基础设施,并制造更智能的系统。目前,这些挑战和研究问题涉及计算机科学的多个领域。

因此,SAML问世。

简单说来,这是一个跨学科的机器学习研究小组,探索跨系统堆栈的多层次问题,包括深度学习框架、训练和推理的专用硬件、新的中间表示、可微编程和各种应用程序。

目前,实验室有四个研究方向。

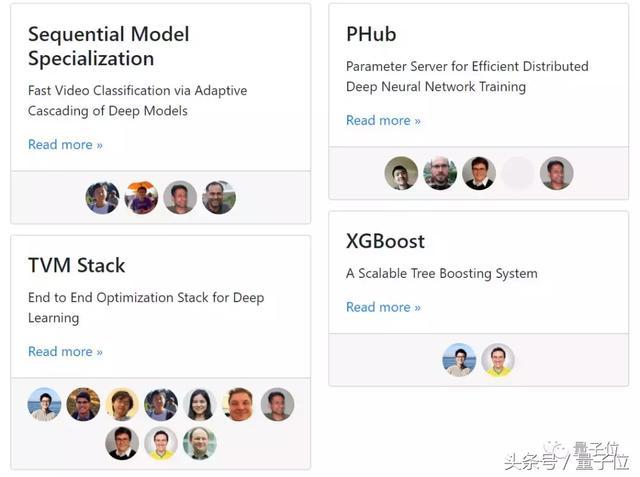

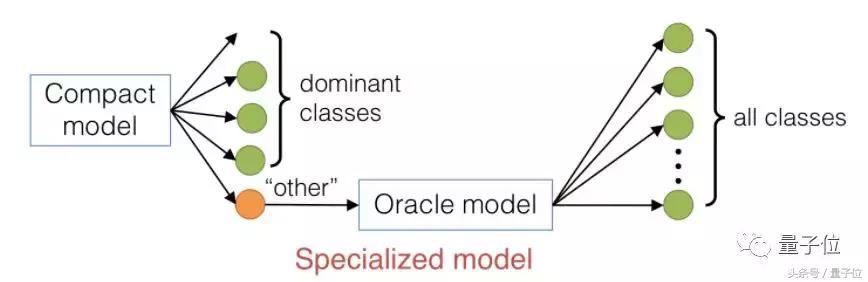

一个方向是序列模型的专门化(Sequential Model Specialization),能通过自适应级联的深度模型为视频快速分类。

研究人员提出了一种级联的廉价分类器架构,并证明了当种类分布高度倾向于小型类集合时,这种专门化的模型准确率相对较高。

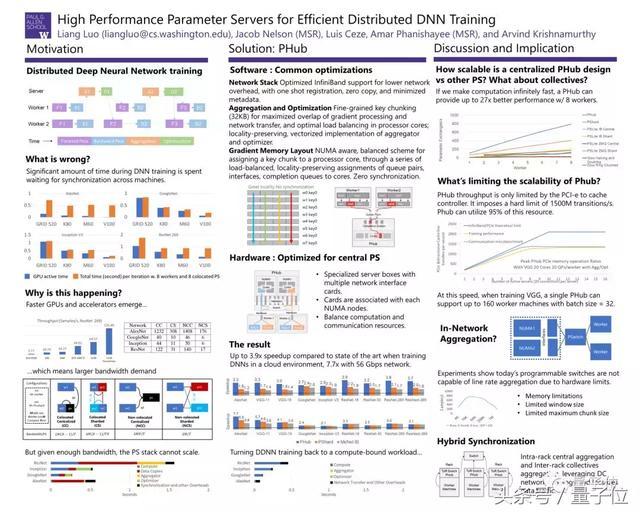

PHub项目是第二个方向,研究内容包括用于高效分布式深度神经网络训练的参数服务器。

这项研究以华盛顿大学和微软研究院的论文Parameter Hub: High Performance Parameter Servers for Efficient Distributed Deep Neural Network Training为基础,探索参数服务器的平衡设计。

论文地址:

https://ift.tt/2rqShP5

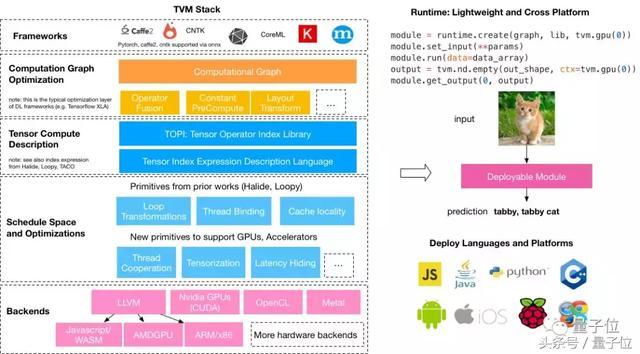

第三个方向以陈天奇团队的TVM堆栈为基础,研究适用于深度学习的端对端优化堆栈。

去年8月,当陈天奇发布TVM时曾引起业内讨论的高潮,通俗点来说,这是一种把深度学习模型分发到各种各样硬件设备上的、端对端的解决方案,包含以下组件:

相关论文地址:

https://ift.tt/2BvyW6g

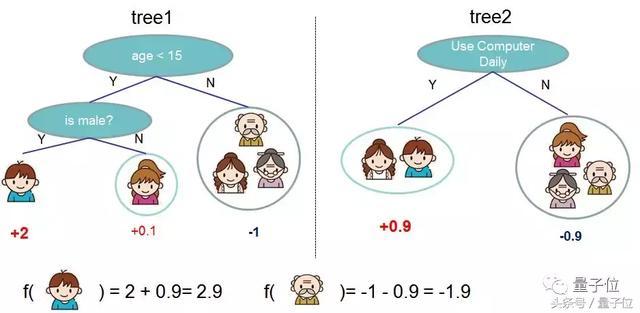

最后一个项目也与陈天奇有关,XGBoost项目是一个高效灵活的可扩展的树状增强系统,在梯度增强的框架下实现了机器学习算法。

相关论文地址:

https://ift.tt/2bHwZVX

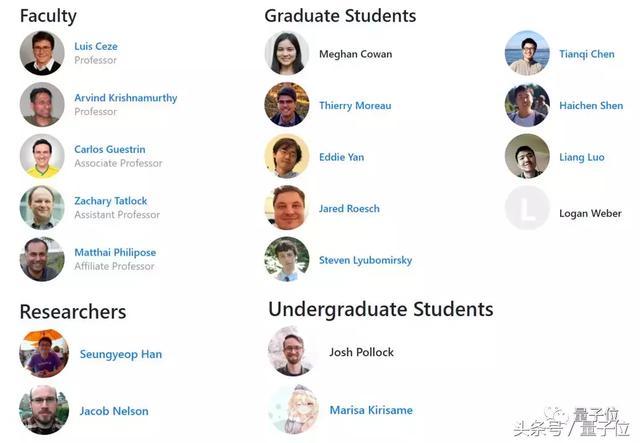

参与团队

目前,项目的参与者均来自华盛顿大学,并由Sampa、Syslab、MODE和PLSE实验室的教师、研究生和本科生组成。

最后,附项目主页地址~

https://ift.tt/2HUvaHV

— 完 —

欢迎大家关注我们的专栏:量子位 - 知乎专栏

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复"招聘"两个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

没有评论:

发表评论